事前分布に独立なラプラス分布を仮定してMAP推定を行なうと、L1正則化の効果が出現する。

-

📄

線形回帰モデル

-

📄

線形回帰モデルの最大事後確率推定

-

📄

線形回帰モデルの最尤推定

-

📄

線形回帰モデルのL2正則化

-

📄

線形回帰モデルのL1正則化

-

📄

線形回帰モデルと正規事前分布

-

📄

線形回帰モデルと正規逆ガンマ事前分布

-

📄

線形回帰と特徴量

-

📄

線形回帰とカーネル法

-

📄

カーネルリッジ回帰

-

📄

事後予測分布

-

📄

事後予測分布とWoodburyの公式

-

📄

事後予測分布とカーネルトリック

-

📄

ガウス過程回帰モデル

ラプラス事前分布

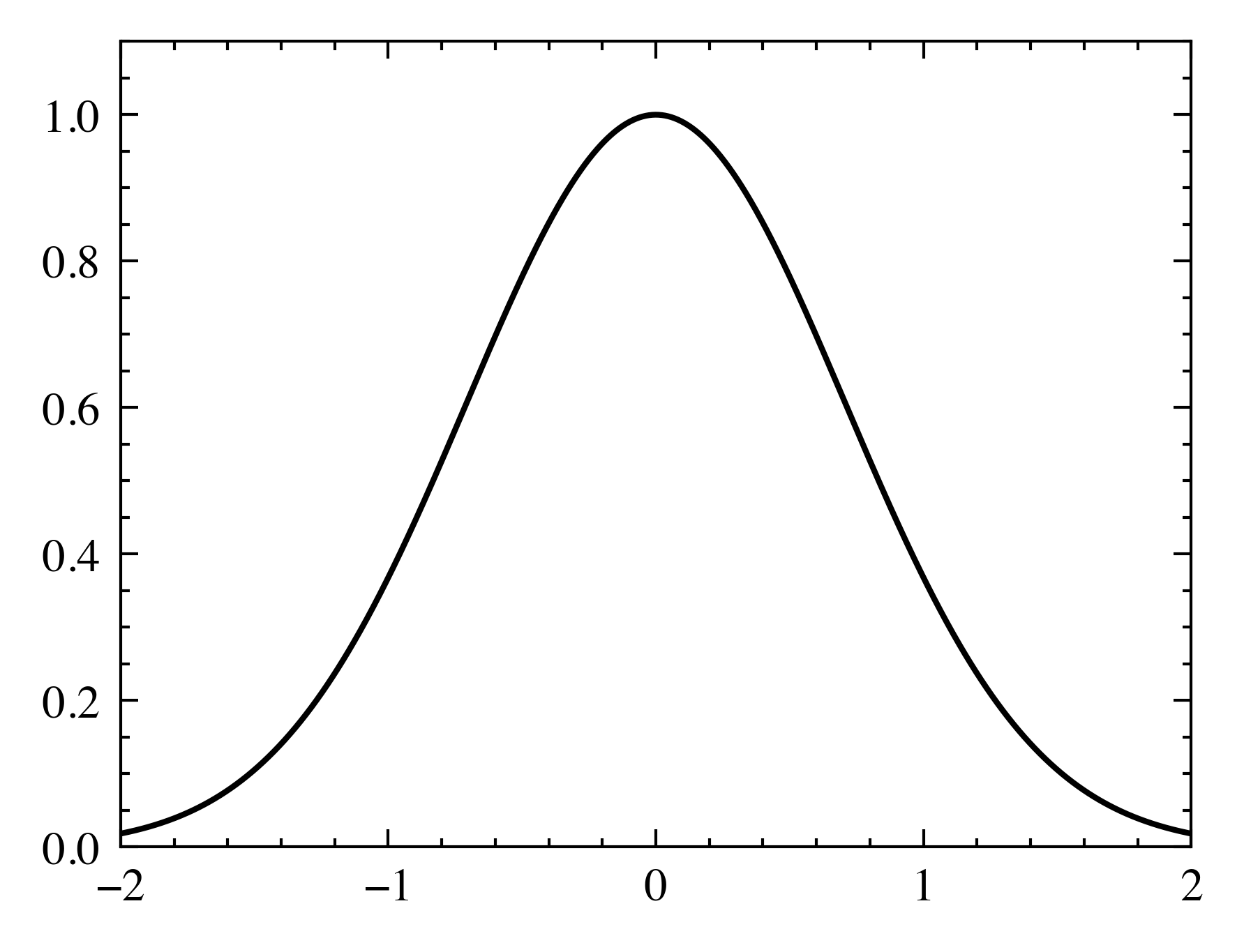

独立な正規分布を事前分布とするMAP推定にはL2正則化の効果がある。これは正規分布の指数関数内にL2ノルムが含まれることに由来する。

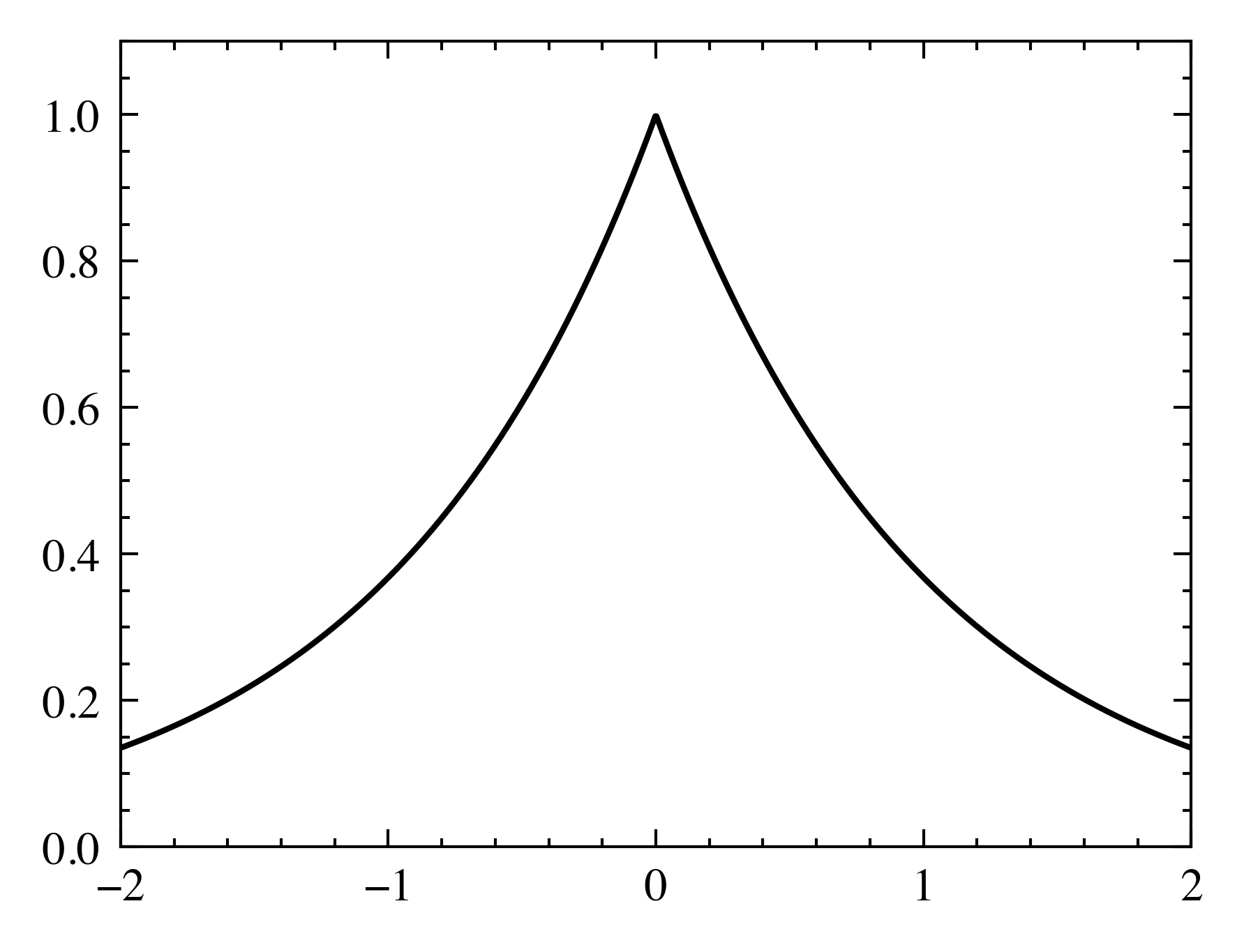

そこで、代わりに次のような指数関数内にL1ノルムが含まれる分布を仮定する。これは ラプラス分布 (Laplace distribution) と呼ばれる分布である。

多変量分布に拡張すると次のようになる。

このとき、事後分布は次の関数に正規化定数が掛けられた形になる。

ただし である。

LASSO

MAP推定量は次式のようになる。

これは次のようなL1ノルム罰金項を含む最適化問題の解である。

ラプラス分布は図2のようにゼロにおいて尖った形をしている。これはパラメータがゼロとなりやすいことを示唆しており、実際、L1ノルム罰金項を追加してパラメータを推定すると、ゼロとなる値が増えやすいことが知られている。このことから、L1ノルム罰金項を含む推定方法はしばしばLASSO (least absolute shrinkage and selection operator; 最小絶対縮小・選択作用素) と呼ばれる。LASSOを用いた回帰は俗にLASSO回帰などと呼ばれる。

L1正則化

目的関数にL2ノルム罰金項を追加することをL2正則化ということを模して、L1ノルム罰金項を追加することを俗にL1正則化 (L1 regularization) という。当然ながら「正則化」のもとの意味である「正則行列化」という意味は失われている。

なお、最小二乗法やRidge回帰は解析的にパラメータを計算することができたのに対し、L1ノルム罰金項を含む場合は目的関数に絶対値が含まれるためかなり難しい。